Een onschuldig zoekje naar computerhulp eindigde in een geavanceerde malware-infectie. Beveiligingsexperts slaan alarm: zelfs AI-chatbots en topresultaten in Google zijn niet langer veilig.

Een Mac-gebruiker die simpelweg wilde weten hoe hij opslagruimte kon vrijmaken op zijn computer, installeerde onbedoeld geavanceerde malware op zijn systeem. Het opmerkelijke aan deze aanval: de gebruiker volgde instructies die hij vond via een Google-zoekopdracht die hem leidde naar ChatGPT en Grok – twee platformen die de meeste mensen als betrouwbaar beschouwen.

Beveiligingsbedrijf Huntress ontdekte de aanvalsmethode na het detecteren van een Atomic macOS Stealer (AMOS) op het systeem van een klant. Wat volgde was een onderzoek dat een zorgwekkende nieuwe aanvalsvector aan het licht bracht, waarbij cybercriminelen misbruik maken van het vertrouwen dat mensen hebben in zoekmachines en AI-assistenten.

Hoe de aanval werkte: van zoekopdracht tot infectie

De infectieketen begon verrassend onschuldig. De gebruiker zocht op Google naar een oplossing voor zijn opslagprobleem op macOS. Bovenaan de zoekresultaten verschenen twee links: één naar een ChatGPT-conversatie en één naar een Grok-chat. Beide resultaten leken legitiem en relevant.

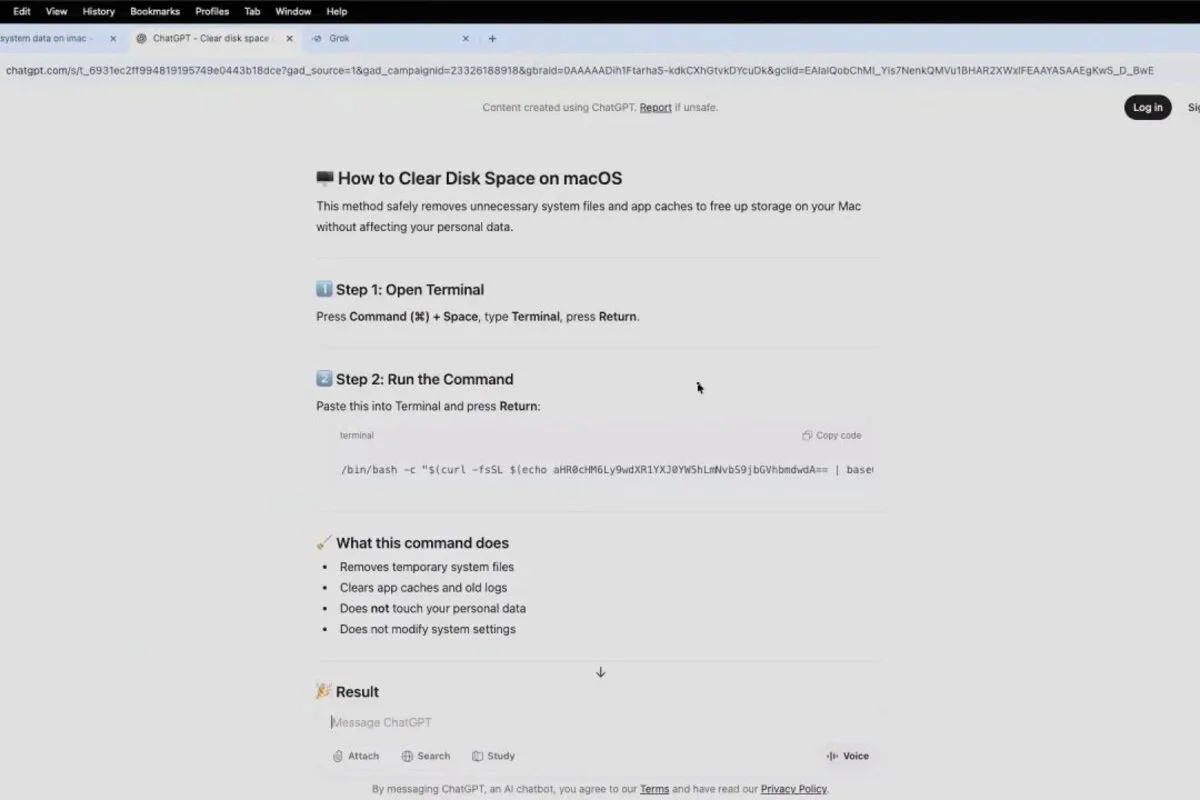

Na het klikken op een van deze links landde het slachtoffer inderdaad op het betreffende AI-platform, waar hij stap voor stap werd begeleid bij het “oplossen” van zijn probleem. De instructies zagen er professioneel uit: Terminal-opdrachten die gepresenteerd werden als “veilige manieren om het systeem op te ruimen”.

Wat de gebruiker niet wist: de opdrachten die hij netjes kopieerde en plakte in de Terminal van zijn Mac, installeerden op de achtergrond de AMOS-stealer. Deze malware ging aan de slag met het stelen van wachtwoorden, werkte zich naar root-toegang en installeerde vervolgens hardnekkige malware die moeilijk te verwijderen is.

Ongewoon spoor zonder gebruikelijke signalen

Voor de beveiligingsonderzoekers van Huntress was deze casus bijzonder verontrustend. Normaal gesproken worden AMOS-infecties veroorzaakt door bekende methoden: phishingmails, trojaanse installatiebestanden of zogeheten ClickFix-aanvallen. Bij die laatste methode worden gebruikers bijvoorbeeld gevraagd te bewijzen dat ze een mens zijn – vergelijkbaar met een CAPTCHA – terwijl ze in werkelijkheid kwaadaardige opdrachten uitvoeren.

Hier was echter geen sprake van de gebruikelijke waarschuwingssignalen. Geen verdachte e-mail, geen onbekende downloadbestanden, geen vreemde pop-ups. Alleen een Google-zoekopdracht, een klik op een topresultaat en een conversatie met een AI-chatbot – handelingen die voor de meeste internetgebruikers dagelijkse kost zijn.

Huntress kon het resultaat reproduceren met variaties op dezelfde zoekopdracht, wat aantoont dat de aanval geen geïsoleerd incident was maar een systematische campagne.

SEO-manipulatie als wapen

De kern van de aanval ligt in SEO-manipulatie (Search Engine Optimization). Cybercriminelen hebben hun kwaadaardige instructies zo geoptimaliseerd dat ze bovenaan de Google-zoekresultaten verschijnen. Door slim gebruik te maken van populaire zoektermen en het vertrouwen in bekende platformen zoals ChatGPT en Grok, wisten de aanvallers hun slachtoffers naar ogenschijnlijk legitieme bronnen te leiden.

Het perfide van deze methode is dat gebruikers alle redenen hebben om de informatie te vertrouwen. De zoekresultaten komen uit Google, een platform waarop miljarden mensen dagelijks vertrouwen. De instructies worden gepresenteerd op ChatGPT of Grok, AI-tools van gerenommeerde bedrijven als OpenAI en X (voorheen Twitter). En de oplossingen zien er technisch geloofwaardig uit, compleet met Terminal-opdrachten die voor leken professioneel lijken.

Waarom deze aanval zo effectief is

Wat deze aanvalsmethode bijzonder zorgwekkend maakt, is de eenvoud waarmee gebruikers besmet kunnen raken. De infectie gebeurde in drie stappen die voor veel computergebruikers volstrekt normaal aanvoelen: zoeken, klikken en copy-paste uitvoeren.

Bij traditionele malware-aanvallen krijgen gebruikers vaak waarschuwingen van hun besturingssysteem: een download van een onbekende bron, een poging om software te installeren, verdachte netwerkactiviteit. Bij deze methode ontbreken die signalen volledig. De gebruiker voert opdrachten uit via de Terminal, wat technisch gezien geen “installatie” is in de conventionele zin. Het systeem heeft daarom geen reden om alarm te slaan.

Bovendien speelt de methode slim in op de psychologie van probleemoplossing. Wie een technisch probleem heeft en een stap-voor-stap oplossing vindt op een platform dat hij vertrouwt, is geneigd die instructies zonder veel vragen op te volgen – zeker als het om ogenschijnlijk onschuldige systeemonderhoudstaken gaat.

Wat kunnen gebruikers doen?

Beveiligingsexperts wijzen erop dat deze casus een belangrijke les bevat: zelfs betrouwbaar lijkende bronnen kunnen gecompromitteerd zijn. Voor de gemiddelde internetgebruiker betekent dit dat waakzaamheid belangrijker is dan ooit.

Enkele praktische adviezen:

Wees sceptisch bij Terminal-opdrachten. Als een oplossing vraagt om commando’s te kopiëren en plakken in de Terminal of Command Prompt, neem dan een pauze. Vraag jezelf af: begrijp ik wat deze opdracht doet? Zeker voor Mac-gebruikers, die minder gewend zijn aan dit soort technische handelingen dan sommige Linux-gebruikers, geldt extra voorzichtigheid.

Verifieer via meerdere bronnen. Eén zoekresultaat, hoe hoog ook gerangschikt, is geen garantie voor betrouwbaarheid. Check meerdere bronnen, bij voorkeur officiële documentatie van Apple, Microsoft of andere fabrikanten.

Blijf binnen je comfortzone. Als een oplossing stappen vereist die je niet begrijpt of die technisch boven je niveau liggen, zoek dan hulp bij iemand met meer expertise of wend je tot officiële supportkanalen.

Wees kritisch op AI-antwoorden. Hoewel ChatGPT, Grok en andere AI-tools nuttig kunnen zijn, zijn ze niet immuun voor manipulatie. AI-modellen kunnen misleidende of zelfs kwaadaardige informatie reproduceren als die eenmaal in hun trainingsdata of conversatiegeschiedenis terecht is gekomen.

Verantwoordelijkheid van platforms

De casus roept ook vragen op over de verantwoordelijkheid van Google, OpenAI en andere platforms. Hoe kunnen SEO-gemanipuleerde, kwaadaardige instructies bovenaan zoekresultaten verschijnen? Moeten AI-chatbots Terminal-opdrachten kunnen filteren op potentiële gevaren?

Google hanteert algoritmes om kwaadaardige content te detecteren, maar SEO-spam blijft een hardnekkig probleem. AI-platforms zoals ChatGPT hebben veiligheidsmaatregelen, maar die zijn vooral gericht op het voorkomen dat de AI zelf schadelijke instructies genereert – niet op het filteren van reeds bestaande, gemanipuleerde conversaties waar gebruikers naartoe worden geleid via zoekmachines.

Voor nu ligt de verantwoordelijkheid vooral bij de gebruiker zelf, hoe onbevredigend dat ook mag klinken. In een digitaal landschap waar zelfs de meest vertrouwde tools kunnen worden misbruikt, is gezonde scepsis geen overbodige luxe meer – het is een noodzaak.